跟着 GPT-4、Stable Diffusion 和 Midjourney 的爆火澳门巴黎人娱乐城,越来越多的东谈主驱动在职责和生计中引入生成式 AI 工夫。

甚而,有东谈主如故驱动尝试用 AI 生成的数据来检修 AI 了。难谈,这等于外传中的「数据永动机」?

但是,来自牛津、剑桥、帝国理工等机构商议东谈主员发现,如若在检修时多数使用 AI 内容,会激发模子崩溃(model collapse),酿成不可逆的舛错。

也等于,跟着时代推移,模子就会健忘简直基础数据部分。即使在简直理念念的长久学习气象下,这个情况也无法幸免。

因此商议东谈主员敕令,如若念念要连续保持大限度数据带来的模子优胜性,就必须肃穆对待东谈主类我方写出来的文本。

AG骰宝

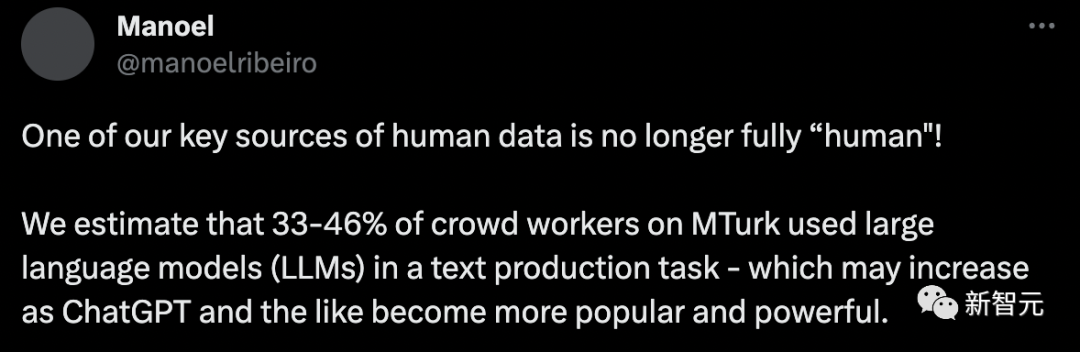

但当今的问题在于 —— 你认为的「东谈主类数据」,可能并不是「东谈主类」写的。

皇冠体育hg86a

洛桑联邦理工学院(EPFL)的最新商议称,预估 33%-46% 的东谈主类数据都是由 AI 生成的。

毫无疑问,当今的大言语模子如故进化出了相配广大的才调,比如 GPT-4 不错在某些场景下生成与东谈主类别无二致的文本。

但这背后的一个迫切原因是,它们的检修数据大部分起原于当年几十年东谈主类在互联网上的交流。

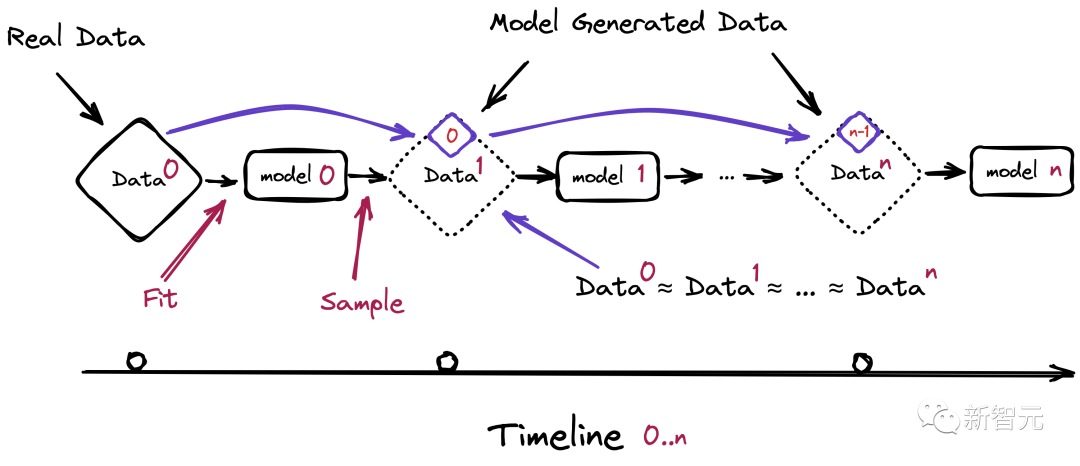

如若改日的言语模子仍然依赖于从网罗上爬取数据的话,就不可幸免地要在检修集合引入我方生成的文本。

对此,商议东谈主员估量,等 GPT 发展到第 n 代的时候,模子将会出现严重的崩溃问题。

那么,在这种不可幸免会捏取到 LLM 生成内容的情况下,为模子的检修准备由东谈主类出产的简直数据,就变得尤为迫切了。

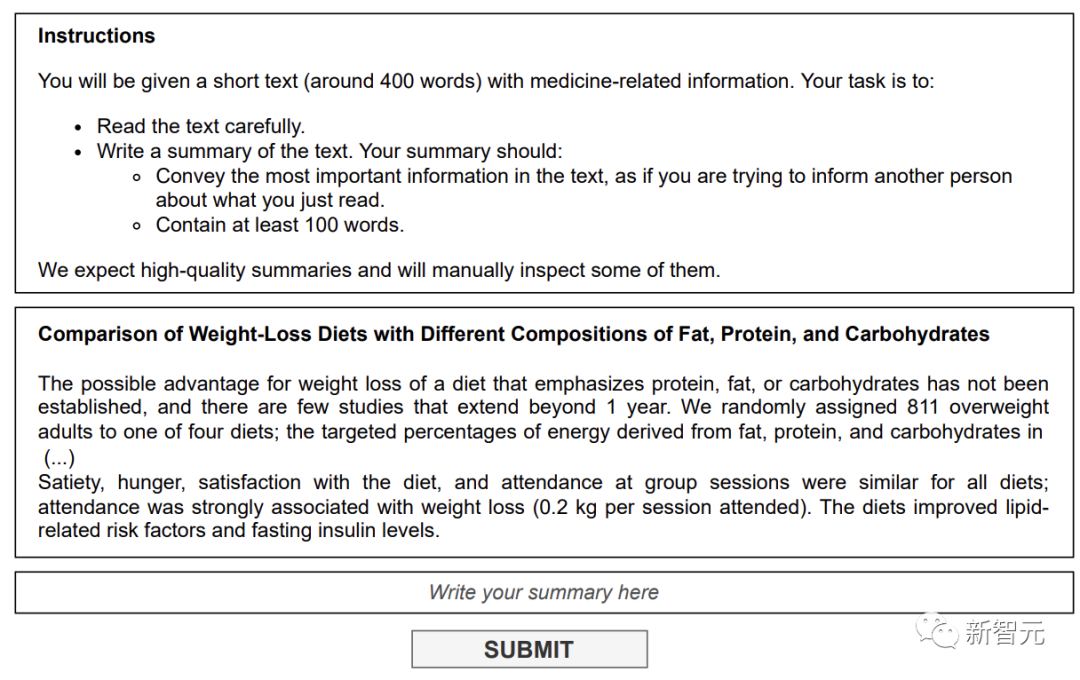

国外赌博网站大名鼎鼎的亚马逊数据众包平台 Mechanical Turk(MTurk)从 2005 年启动时就如故成为好多东谈主的副业取舍。

科研东谈主员不错发布多样琐碎的东谈主类智能任务,比如给图像标注、打听等,应有尽有。

而这些任务频繁是盘算机和算法无法处理的,甚而,MTurk 成为一些预算不够的科研东谈主员和公司的「最好取舍」。

就连贝索斯还将 MTurk 的众包工东谈主戏称为「东谈主工东谈主工智能」。

除了 MTurk,包括 Prolific 在内的众包平台如故成为商议东谈主员和行业实践者的中枢,能够提供创建、标注和回首多样数据的阵势,以便进行打听和实验。

但是,来自 EPFL 的商议发现,在这个东谈主类数据的要道起原上,有近乎一半的数据都是标注员用 AI 创建的。

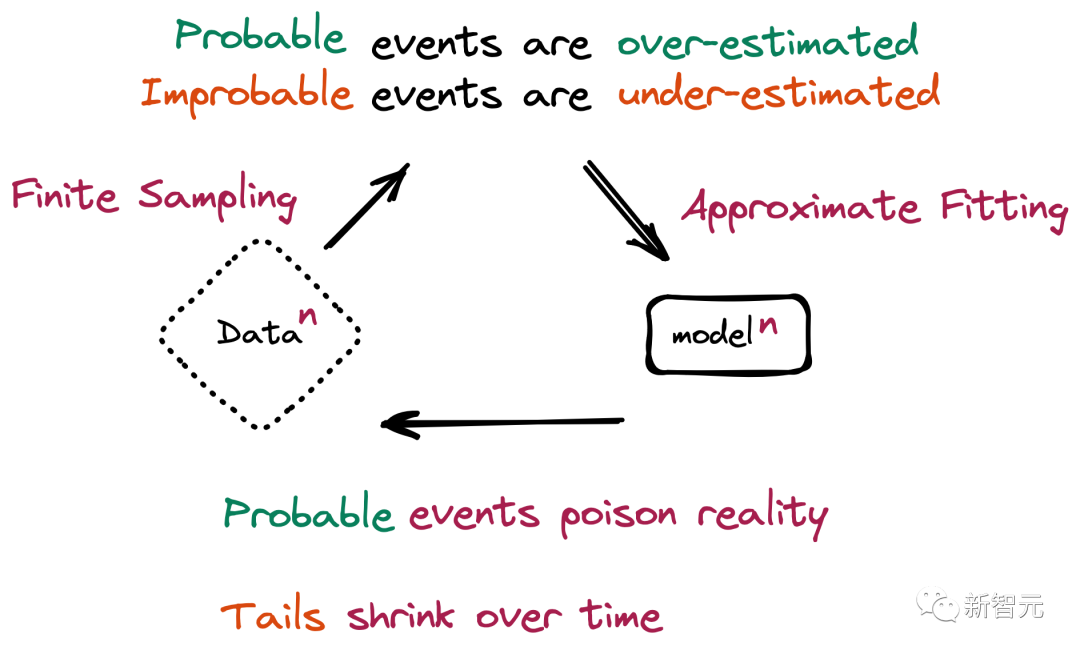

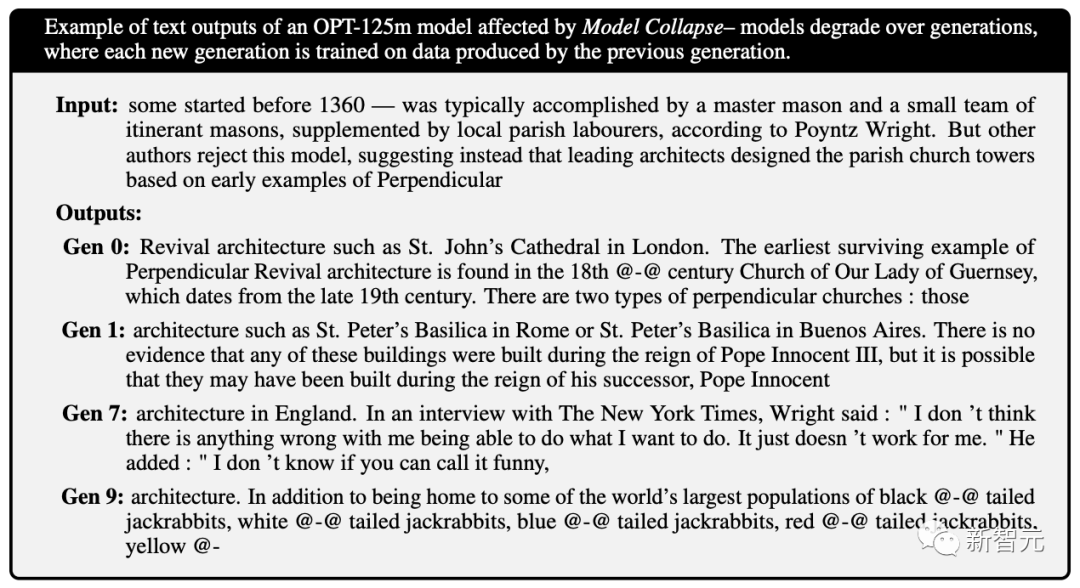

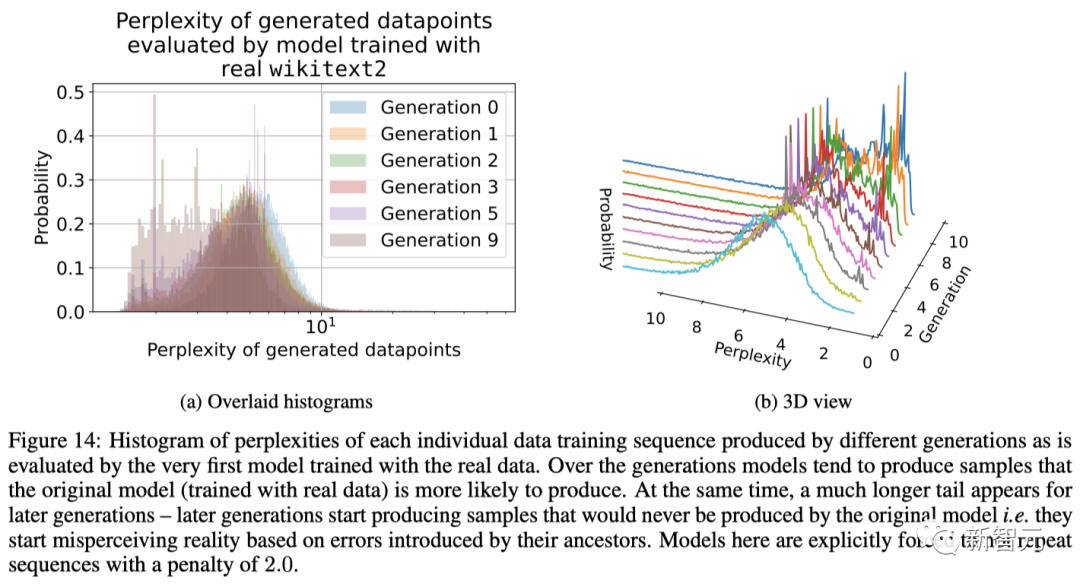

而最驱动提到的「模子崩溃」,等于在给模子投喂了太多来自 AI 的数据之后,带来的能够影响多代的退化。

也等于,新一代模子的检修数据会被上一代模子的生成数据所沾污,从而对本质天下的感知产生造作的明白。

更进一步,这种崩溃还会激发比如基于性别、种族或其他明锐属性的敌对问题,尤其是如若生成 AI 跟着时代的推移学会在其反映中只生成某个种族,而「健忘」其他种族的存在。

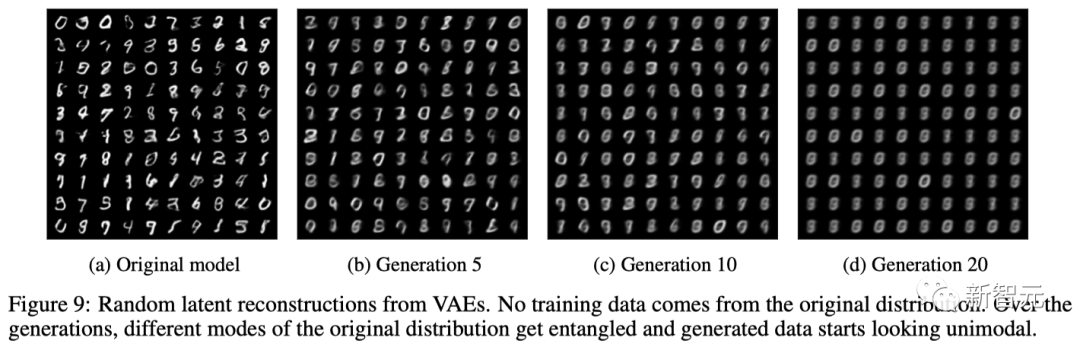

而且,除了大言语模子,模子崩溃还会出当今变分自编码器(VAE)、高斯搀和模子上。

近期,越来越多的电竞选手加入到国际比赛中,赛事的激烈程度也越来越高。想要了解最新的电竞比赛动态和选手资讯,不妨加入皇冠体育博彩平台,与全球电竞爱好者一起探讨和分享。需要详确的是,模子崩溃的流程与不悠然性渐忘(catastrophic forgetting)不同,模子不会健忘以前学过的数据,而是驱动把模子的造做念法曲解为本质,况且还会强化我方对造做念法的信念。

举个例子,比如模子在一个包含 100 张猫图片的数据集上进行检修,其中有 10 张蓝毛猫,90 张黄毛猫。

模子学到的论断是,黄毛猫更宽阔,同期会倾向于把蓝毛猫念念象的比本色更偏黄,是以在被条款生成新数据时可能会复返一些雷同绿毛猫的规定。

而跟着时代的推移,蓝毛的原始特征在多个检修 epoch 中慢慢被侵蚀,径直从蓝色变成了绿色,最终再演变为黄色,这种渐进的扭曲和丢失少数特征的征象等于模子崩溃。

具体来说,模子崩溃不错分为两种情况:

1. 早期模子崩溃(early model collapse),模子驱动丢失联系散布尾部的信息;

2. 后期模子崩溃(late model collapse),模子与原始散布的不同模式纠缠在沿途,并经管到一个与原始散布简直莫得相似之处的散布,不绝方差也会特地小。

与此同期,商议东谈主员也回首出了酿成模子崩溃的两个主要原因:

其中,在更多的时候,咱们会得到一种级联效应,即单个不准确的组合会导致合座差错的加多。

皇冠客服飞机:@seo36871. 统计近似差错(Statistical approximation error)

关于公开征集全国和美乡村篮球大赛 (村BA)标识、主题曲、吉祥物 设计的公告

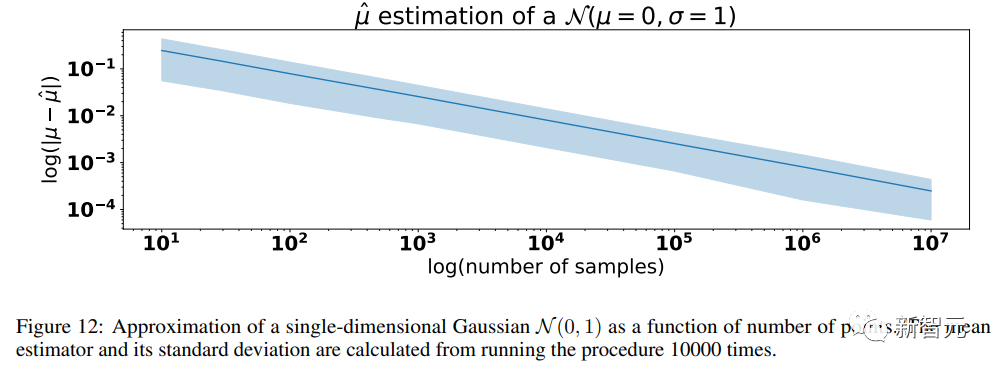

在重采样的每一步中,信息中非零概率都可能会丢失,导致出现统计近似差错,当样本数目趋于无尽会慢慢隐藏,该差错是导致模子崩溃的主要原因。

2. 函数近似差错(Functional approximation error)

该差错主要源于模子中的函数近似器抒发才调不及,或者偶然在原始散布解救除外的抒发才调太强。

体育博彩技巧各人皆知,新2在线客服神经网罗在极限情况下是通用的函数近似器,但本色上这种假定并不老是设置的,零碎是神经网罗不错在原始散布的解救范围除外引入非零似然。

举个简便例子,如若咱们试图用一个高斯散布来拟合两个高斯的搀和散布,即使模子具联系于数据散布的竣工信息,模子差错亦然不可幸免的。

需要详确的是,在莫得统计差错的情况下,函数近似差错只会发生在第一代,一朝新的散布能被函数近似器描写出来,就会在各代模子中保持都备相通的散布。

不错说,模子广大的近似才调是一把双刃剑:其抒发才调可能会对消统计噪声,从而更好地拟合简直散布,但雷同也会使噪声复杂化。

对此,论文共并吞作 Ilia Shumailov 默示:「生成数据中的造作会积贮,最终迫使从生成数据中学习的模子进一步造作地明白本质。而且模子崩溃发生得特地快,模子会飞快健忘起入门习的大部分原始数据。」

好在,商议东谈主员发现,咱们照旧有宗旨来幸免模子崩溃的。

第一种阵势是保留原始的、都备或口头上由东谈主类生成的数据集的高质料副本,并幸免与 AI 生成的数据搀和,然后如期使用这些数据对模子进行从新检修,或者都备重新检修一遍模子。

第二种幸免回复质料下跌并减少 AI 模子中的造作或相通的阵势是将全新的、干净的、由东谈主类生成的数据集从新引入检修中。

皇冠正规足球为了回绝模子崩溃,开荒者需要确保原始数据中的少数派在后续数据集合得到自制的表征。

数据需要仔细备份,并遮蔽所有可能的畛域情况;在评估模子的性能时,需要有筹商到模子将要处理的数据,甚而是最不着实的数据。

随后,当从新检修模子时,还需要确保同期包括旧数据和新数据,诚然会加多检修的资本,但至少在某种进度上有助于缓解模子崩溃。

不外,这些阵势必须要内容制作家或 AI 公司遴选某种大限度的象征机制,来分裂 AI 生成的内容和东谈主类生成的内容。

体育博彩现时,有一些开箱即用的科罚决策,比如 GPTZero,OpenAI Detector,或 Writer 在简便的文本上职责得很好。

欧博网址

但是,在一些特殊的文本中,这些阵势并不可灵验引申。比如,在 EPFL 商议中有 ChatGPT 合成的 10 个回首,而 GPTZero 只检测到 6 个是合成的。

对此,商议东谈主员通过微调我方的模子来检测 AI 的使用,发现 ChatGPT 在编写本文时是最常用的 LLM。

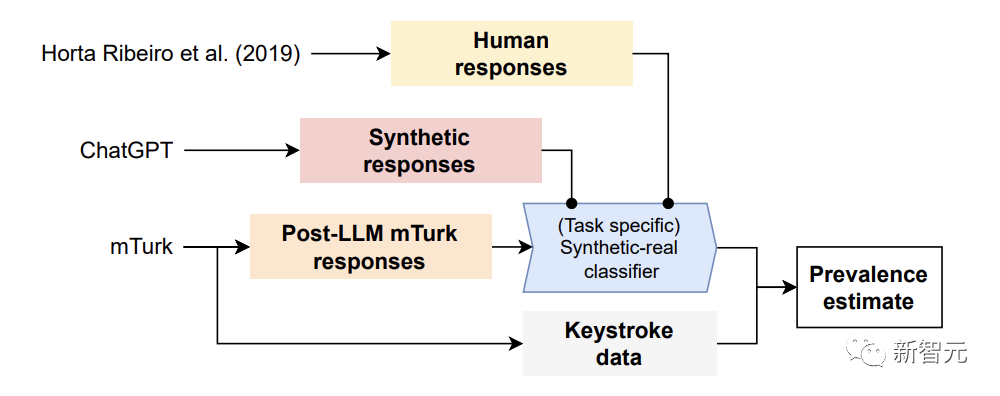

关于构建的检测 AI 数据的阵势,商议东谈主员诈欺原始商议中的谜底和用 ChatGPT 合成的数据,检修了一个定制的「合成-简直分类器」。

然后用这个分类器来猜度从新进行的任务中合成谜底的宽阔性。

具体来讲,商议东谈主员起初使用真确由东谈主类撰写的 MTurk 复兴,和合成 LLM 生成的复兴,来检修特定任务的「合成-简直分类器」。

其次,将这个分类器用于 MTurk 的简直复兴(其中众包东谈主可能使用,也可能莫得依赖 LLM),以猜度 LLM 使用的宽阔性。

博彩评价终末,商议者证明了规定的灵验性,在过后相比分析击键数据与 MTurk 的复兴。

实验规定披露,这个模子在正确识别东谈主工智能文本方面高达 99% 的准确率。

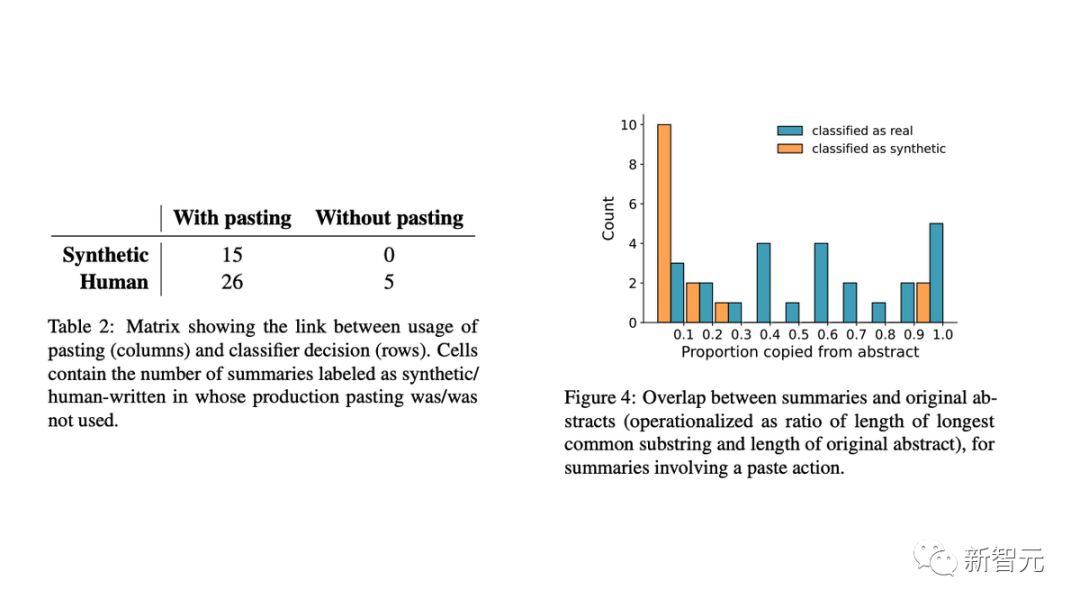

此外,商议东谈主员用击键数据考据了规定,发现:

- 都备在 MTurk 文本框中写的回首(不太可能是合成的)都被归类为简直的;

- 在粘贴的回首中,提真金不怕火式回首和 LLM 的使用有彰着区别。

具体来讲,东谈主工智能生成的文本频繁与原始回首简直莫得相似之处。这标明 AI 模子正在生成新文本,而不是复制和粘贴原始内容的一部分。

当今,东谈主们宽阔缅念念 LLM 将塑造东谈主类的「信息生态系统」,也等于说,在线可赢得的大部分信息都是由 LLM 生成的。

使用详细生成数据检修的 LLM 的性能彰着裁汰,就像 Ilia Shumailov 所称会让模子患上「古板症」。

而这个问题将会变得愈加严重,因为跟着 LLM 的普及,众包职责者们如故庸碌使用 ChatGPT 等多样 LLM。

但关于东谈主类内容创作家来说,这是一个好讯息,擢升职责规定的同期,还赚到了钱。

但是,若念念赈济 LLM 不陷于崩溃的旯旮,照旧需要简直的「东谈主类数据」。

1. 东谈主类数据在科学中仍然是至关迫切的

2. 在合成数据上检修模子可能会带来偏见和意志形态长久化

3. 跟着模子变得流行和更好 / 多模态,选拔率只会加多

总的来说,由东谈主类生成的原始数据不错更好地默示天下,诚然也可能包含某些劣质、概率较低的数据;而生成式模子不绝只会过度拟合流行数据,并对概率更低的数据产生诬陷。

那么,在充斥着生成式 AI 器用和相关内容的改日,东谈主类制作的内容概况会比今天更有价值,尤其是行为 AI 原始检修数据的起原。

参考贵府:

本文来自微信公众号:新智元 (ID:AI_era)澳门巴黎人娱乐城

声明:新浪网独家稿件,未经授权不容转载。 -->